先说几个场景:

1、 数据滥用:以前谈数据安全,可能会更倾向于安全漏洞背景。但在很多运营场景中,有权限的人需要访问用户,例如风控、BI、运营、客服等人员就需要能够访问用户数据。Uber以前有个“God View”系统,内部工作人员可以查看骑手和路线信息,被爆出来以后,Uber的对应措施是多因素验证员工身份,建立了一个审计系统。但实际上到今天,还有爆料说,员工可以用这个系统查之前的女朋友信息,跟踪位置,也可以查看名一些名人的电话号码,而且有个员工吹嘘自己可以拿到Facebook首席执行官马克扎克伯格的电话。这实际上就是对数据权限的滥用,也侵犯了用户隐私。国内这种情况想必更严重。

2、 大数据采集泛滥:这就不用多解释了,各种APP,智能家居都在收集各类信息,而这种收集来的数据会被冠以用户画像、精准营销向外出售。大家熟知的某些小区宽带运营商,某些广告推送服务,几乎所有的APP,都这德行。

哦不好意思,我站错队了。我要说的其实是:在用户隐私越发被看重的情况下,作为一个公司,应该如何在保护隐私的情况下进行数据分析?也逐渐成为各大公司研究的重要课题。

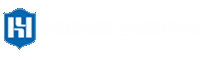

获得数据后,在分析场景下有两个常见用途,一是用来做业务决策分析,二是机器学习的自动化。在这些类型下,既要保护用户隐私,又要保留分析价值,业界实际上一直在尝试。

一、商业智能分析

业界的一些探索,例如Intel的SGX,提供了一个敏感数据分析的飞地。还有一些加密数据查询使用的方法,例如HElib,可以快速实现同态加密(https://shaih.github.io/HElib/)。

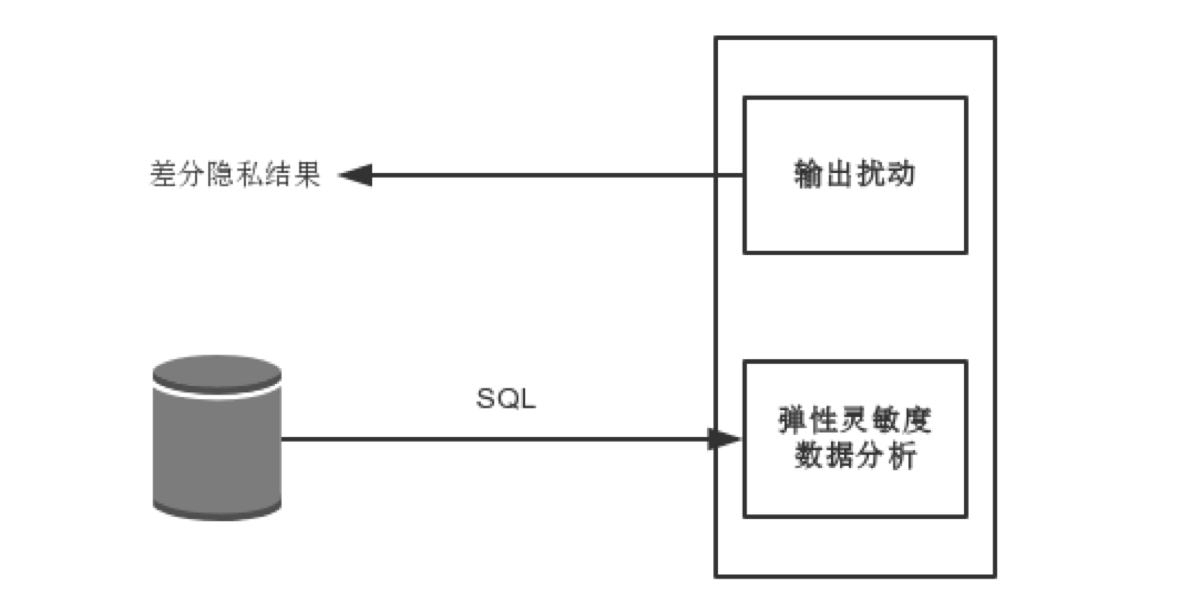

Uber和加州大学有一个合作研究,大体的意思如下:

这是个服务端差分隐私的方案,BI可以提交查询SQL,在经过扰动加噪后,得到分析结果,这个分析结果能够保证用户隐私。这个系统已经开源,国内几家大厂商也是基于这一方案实现,开源地址(https://github.com/uber/sql-differential-privacy)。

上面方案是一个在测试环境下实现的,但在大规模实时场景下是否可以构建?Apple和Google也都在采用这个方法,Google的也进行了开源,https://github.com/google/rappor。

Apple的本地差分隐私,是在客户端即开始保护,例如对表情符号使用热度的采集,使用了类似投硬币的方式。此外限制了每个用例的上传数量,数据到达服务器后,丢弃设备标识和ip信息,另外多个记录之间的关联信息也丢弃。这样就无法区分用户信息,而只进行统计数据计算。

二、机器学习

2016年Google开始在工程上实践,而且应用在了出Android Wear智能设备和Mobile Vision 的API上,能够把训练数据分发到移动端,然后通过聚合学习在本地进行计算更新。

以智能设备为例,整个过程分为三个阶段:

1、每个设备总结模型更改,发送到云(云上是加密的)。

2、将更改和其他用户的更改进行平均,改进共享模型。

3、训练数据保留在每个设备上,不存储任何个人更改。

Google的案例是共享单个模型学习,而不共享数据。但在某些场景下,需要高度个性化模型,因此需要多任务学习,实现个性化深度学习模型,目标则是同时拟合单独的,但多个相关的模型。

转载请注明来自网盾网络安全培训,本文标题:《BI和机器学习中的隐私保护》

- 上一篇: 青莲晚报(第十七期)| 物联网安全多知道

- 下一篇: 防御Mimikatz攻击的方法介绍